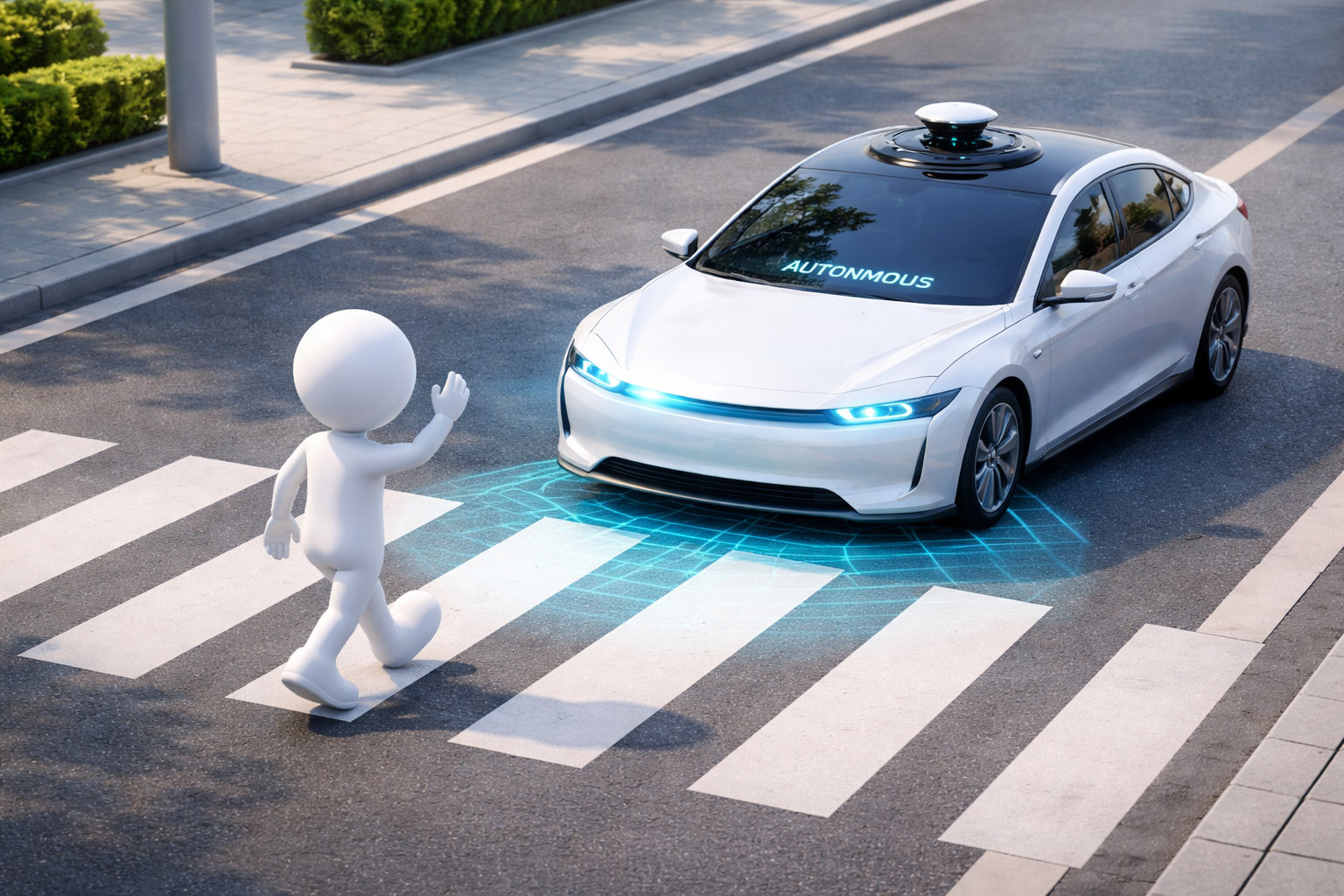

자율주행 기술은 더 이상 먼 미래의 이야기가 아닙니다. 최근 공개된 테슬라의 FSD(Full Self-Driving) 영상이나 포티투닷의 주행 영상을 보면, AI는 이미 복잡한 도심과 터널을 누비고 있습니다.

하지만 기술이 고도화될수록 우리가 던져야 할 질문은 "가능한가?"에서 "안전한가?"로 바뀌어야 합니다.

오늘은 자율주행 AI의 안전을 바라보는 두 가지 뚜렷한 시각, 즉 '극한의 검증 실험'을 강조하는 관점'과 '방대한 실전 데이터'를 중시하는 테슬라의 관점을 비교 분석해 보겠습니다.

1. 사고 나기 전에 흔들어라 (Simulation & Verification)

"AI가 어디서 무너지는지 사전에 확인해야 한다"는 것입니다.

사고가 발생한 뒤에 원인을 분석하는 것은 너무 늦습니다.

따라서 이 관점에서는 AI를 의도적으로 '흔드는' 실험을 제안합니다.

- 극한의 환경 조성 (합성 데이터): 현실에서 폭설, 안개, 역광 등 모든 악천후를 기다려 테스트하기란 불가능에 가깝습니다. 이를 해결하기 위해 '베리파이 V(Verify V)'와 같은 합성 엔진을 사용해 AI에게 가상의 눈을 내리게 하고, 계절을 겨울로 바꾸어 버립니다.

- 경계선 찾기: 단순히 AI를 망가뜨리는 것이 목적이 아닙니다. 화면에 노이즈를 주거나 흐리게 만들었을 때, AI의 판단이 '안전(초록)'에서 '주의(노랑)', 그리고 '위험(빨강)'으로 변하는 그 임계점을 찾는 것이 목표입니다.

- 흔들림은 곧 신호: 이 관점에서 AI의 판단 오류는 실패가 아니라, 안전을 보강해야 할 중요한 '신호'로 해석됩니다. 즉, 시뮬레이션을 통해 사전에 취약점을 파악하고 보완하는 '선제적 검증'이 핵심입니다.

2. 압도적인 데이터로 학습하라 (Real-world Data & End-to-End)

반면, 테슬라로 대표되는 상용화 선두 주자들의 접근 방식은 '실제 도로 위에서의 경험'을 최우선으로 둡니다.

- End-to-End 모델: 과거처럼 인지, 판단, 제어를 쪼개지 않고 통째로 학습합니다. 이는 최신 트렌드로, 복잡한 상황에서 유연하게 대처하는 능력을 키워줍니다.

- 실전이 곧 테스트: 전 세계에 깔린 수백만 대의 차량이 매일 겪는 실제 주행 상황이 곧 데이터가 됩니다. 특이한 코너 케이스(Corner Case)를 시뮬레이션으로 만들기보다, 실제로 주행하며 겪은 데이터를 수집해 AI를 재학습시키는 방식입니다.

- 감독형 학습: 운전자가 개입하는 순간을 포착하여 AI가 무엇을 잘못했는지 배우게 합니다. 실전에서의 시행착오를 통해 모델을 끊임없이 진화시키는 전략입니다.

3. 비교 및 결론: 안전은 어떻게 완성되는가?

두 관점은 서로 다르지만, 결국 '안전'이라는 하나의 목표를 향해 갑니다.

- 테슬라가 방대한 '경험의 양'으로 일반적인 상황에서의 대응력을 극대화한다면,

- 검증 기술은 현실에서 마주하기 힘든 '극한의 조건'을 시뮬레이션하여 AI의 내구성을 사전에 증명합니다.

자율주행 AI의 안전은 기술 그 자체만으로 완성되지 않습니다.

테슬라처럼 잘 달리는 것도 중요하지만, 검증 실험을 통해 "우리 AI는 눈 오는 밤, 조도가 30% 떨어지는 구간부터 성능이 저하된다"는 사실을 미리 알고 대비하는 것이 진정한 의미의 안전 설계일 것입니다.

AI의 흔들림을 미리 파악하고 이를 통제 가능한 영역으로 가져오는 것, 그것이 자율주행 상용화의 마지막 퍼즐입니다.

3. 자율주행 AI의 안전을 보장하기 위해 제정된 대표적인 국제 규격들

극한 상황에서의 테스트, 환경 변화에 따른 검증 특히 ISO 21448(SOTIF)과 아주 밀접한 관련이 있습니다.

주요 국제 규격들을 알기 쉽게 정리해 드립니다.

1. ISO 26262 (기능 안전, Functional Safety)

- 핵심: "고장이 났을 때 안전한가?"

- 내용: 자율주행차의 부품(센서, 제어기 등)이나 소프트웨어에 오류나 고장이 발생했을 때, 사고가 나지 않도록 설계하는 것에 대한 표준입니다.

- 예시: 브레이크 센서가 고장 나면 비상 제동 장치가 작동하게 만드는 것 등이 여기에 속합니다. 기존 자동차 산업에서 가장 기본이 되는 규격입니다.

2. ISO 21448 (SOTIF, 의도된 기능의 안전)

- 핵심: "고장은 없는데, AI가 착각하면 어떡하지?" (Safety of the Intended Functionality)

- 내용: 시스템이나 부품에는 아무런 고장이 없는데, 성능의 한계나 인지 오류로 인해 발생하는 위험을 다룹니다.

- 연관성: 질문자님이 공유해주신 '눈/비 오는 환경', '역광', '안개' 등의 상황에서 AI가 제대로 판단하는지 검증하는 실험이 바로 이 규격을 만족시키기 위한 과정입니다. AI가 미처 학습하지 못한 상황(Unknown Unsafe)을 찾아내어 안전한 영역(Known Safe)으로 만드는 것이 목표입니다.

3. UL 4600 (자율주행 시스템 안전 평가)

- 핵심: "안전하다는 것을 어떻게 증명할 것인가?"

- 내용: 완전 자율주행(레벨 4, 5)을 위해 만들어진 민간 표준입니다. 단순히 테스트를 통과했는지가 아니라, '우리는 충분히 안전하다'는 논리적인 근거(Safety Case)를 제시하도록 요구합니다.

- 특징: 머신러닝/AI의 불확실성을 인정하고, 이에 대한 검증 과정을 매우 중요하게 다룹니다.

4. ISO/SAE 21434 (차량 사이버 보안)

- 핵심: "해킹 당하면 어떡하지?"

- 내용: 자율주행차는 통신이 필수적이므로, 외부의 해킹 공격으로부터 차량을 보호하기 위한 보안 표준입니다.

'합성 데이터 실험'과 '환경 변화 테스트'는 단순히 기술 자랑을 위한 것이 아니라, ISO 21448 (SOTIF) 규격을 충족하기 위한 필수적인 절차입니다.

국제 규격은 이제 "부품이 안 고장 나게 만들어라(ISO 26262)"를 넘어, "AI가 눈보라 속에서도 헷갈리지 않게 검증해라(ISO 21448)"라고 요구하고 있기 때문에, 그러한 검증 솔루션과 실험들이 중요해지는 것입니다.

자율주행, AI안전성, 테슬라FSD, 합성데이터, 모델검증, 시뮬레이션, 딥러닝, 자율주행테스트, End-to-End, 모빌리티기술

'인공지능(AI) > AI test' 카테고리의 다른 글

| AI 안전, 어떻게 테스트하고 대비할 것인가? 위험 탐지부터 글로벌 동향까지 (0) | 2025.12.03 |

|---|---|

| SW 테스팅의 패러다임 전환: AI가 열어가는 새로운 품질의 시대 (0) | 2025.10.22 |

| 초보자도 따라 할 수 있는 LLM 테스트 A to Z (4) | 2025.07.25 |

| AIT-AI Test Training에 대해 알아보니.. (0) | 2025.03.18 |

| chat gpt o1(OpenAI o1)에 대해 알아보니.. (0) | 2024.09.15 |